Lời nói đầu:NVIDIA ra mắt Vera Rubin tại CES 2026: Siêu chip AI giảm 10 lần chi phí token, tăng 5 lần hiệu suất, định hình cuộc đua nhà máy AI tỷ đô trước thách thức từ AMD, Google và Amazon.

Tại CES 2026, NVIDIA không chỉ ra mắt một con chip mới mà còn thiết lập một tiêu chuẩn mới cho nền tảng AI tương lai, hứa hẹn giảm 4 lần GPU huấn luyện và 10 lần chi phí vận hành, trong bối cảnh cạnh tranh khốc liệt với AMD và chính những khách hàng lớn nhất của mình.

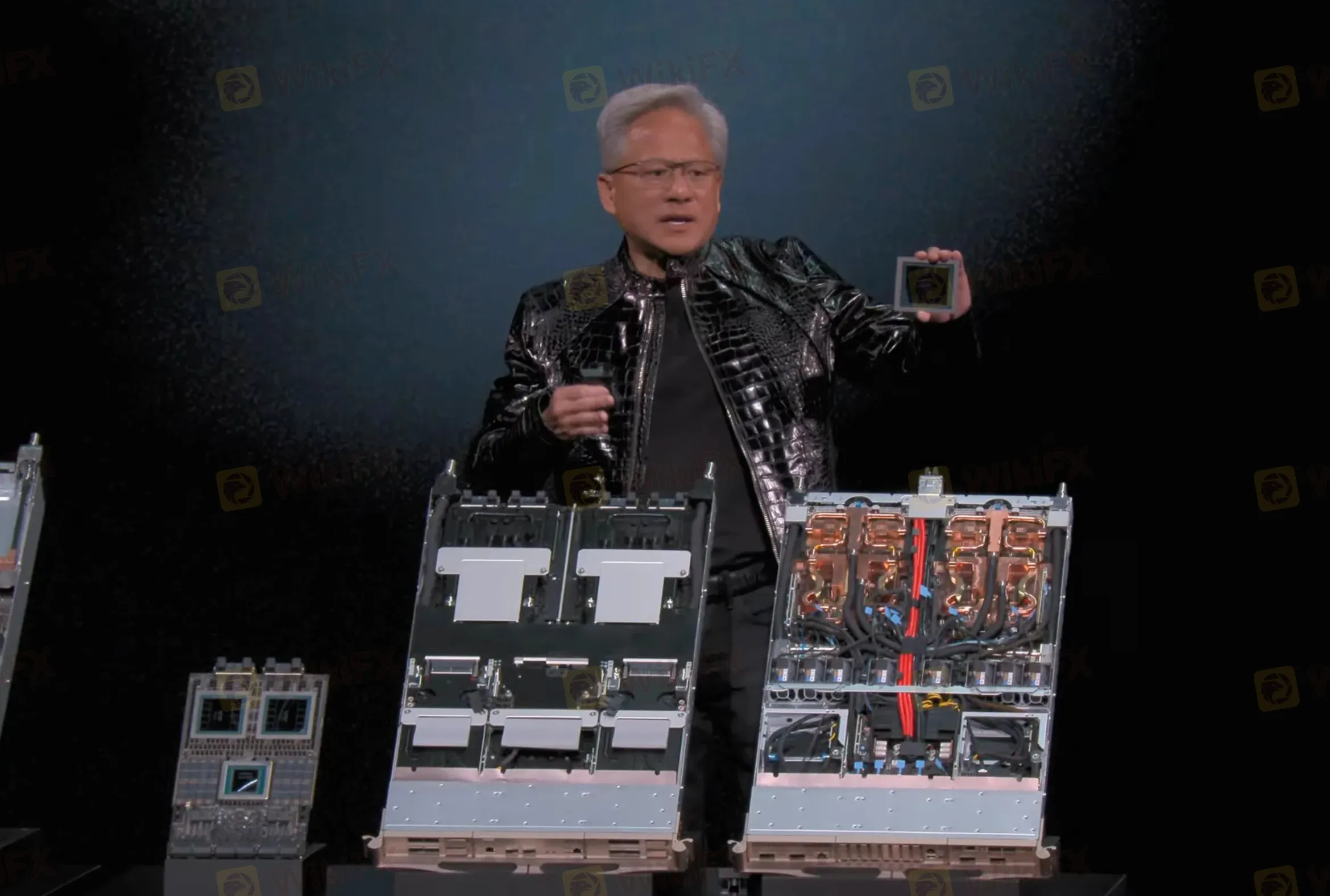

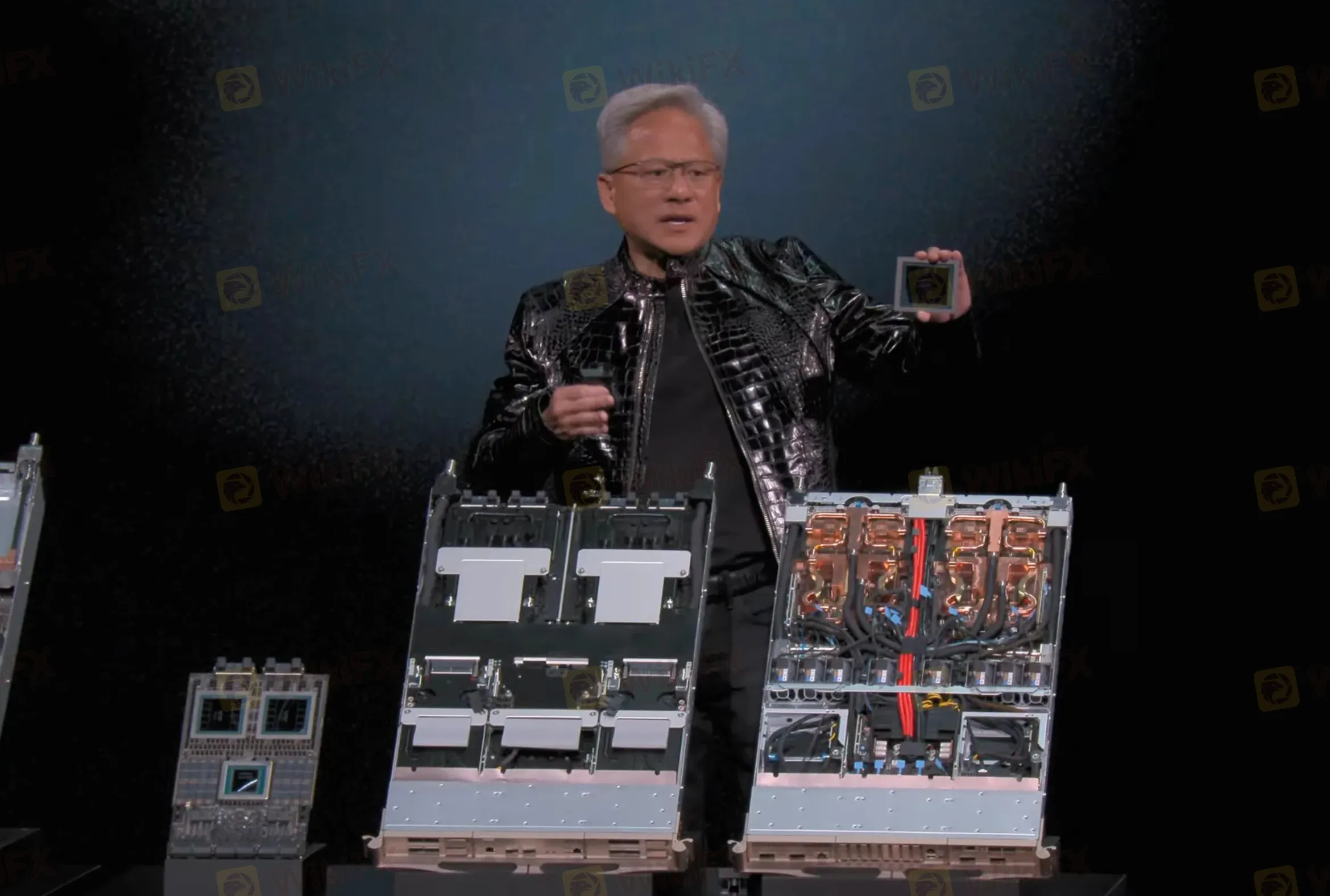

Sau thế hệ Grace Blackwell đình đám, NVIDIA tiếp tục khẳng định vị thế dẫn đầu không thể tranh cãi trong cuộc đua bán dẫn AI với việc công bố nền tảng Vera Rubin tại CES 2026. Đây không phải là một bản nâng cấp đơn thuần, mà là một hệ sinh thái tính toán hoàn chỉnh, được tối ưu hóa cực độ cho tương lai của các mô hình AI tác nhân (agentic AI) và lý luận tiên tiến (advanced reasoning).

Ra mắt trong bối cảnh nhu cầu điện toán AI cho cả huấn luyện và suy luận đang “xuyên thủng mái nhà” - như lời CEO Jensen Huang - Rubin hứa hẹn mang lại hiệu quả đột phá: giảm 4 lần số GPU cần để huấn luyện và cắt giảm 10 lần chi phí token suy luận.

Tham vọng của NVIDIA còn thể hiện qua việc rút ngắn chu kỳ đổi mới xuống còn một năm, một tốc độ chưa từng có trong ngành công nghiệp bán dẫn, nhằm thiết lập khoảng cách không thể bắt kịp với các đối thủ như AMD và cả những khách hàng đang tự phát triển chip riêng như Google hay Amazon.

Kiến trúc đột phá

Nền tảng Rubin đại diện cho triết lý thiết kế mới của NVIDIA: “đồng thiết kế cực độ” (extreme codesign). Thay vì phát triển riêng lẻ từng thành phần, sáu con chip hoàn toàn mới được thiết kế đồng bộ từ đầu để hoạt động như một hệ thống thống nhất, loại bỏ các điểm nghẽn (bottleneck) vốn có khi kết hợp linh kiện từ nhiều nguồn khác nhau.

Trái tim của nền tảng là Vera Rubin Superchip, kết hợp một CPU Vera và hai GPU Rubin trong một gói duy nhất. CPU Vera, với 88 nhân Olympus tùy chỉnh, được tối ưu cho việc di chuyển dữ liệu và xử lý tác nhân AI, cung cấp băng thông bộ nhớ lên đến 1.2 TB/s. GPU Rubin thì cung cấp 50 petaflops hiệu suất tính toán NVFP4, được trang bị động cơ Transformer thế hệ thứ ba cho suy luận AI.

Tuy nhiên, sức mạnh thực sự nằm ở bốn con chip chuyên biệt khác tạo nên hệ sinh thái:

- NVLink 6 Switch: Thế hệ thứ sáu của công nghệ kết nối scale-up, cung cấp 3.6 TB/s băng thông GPU-to-GPU, là mạch máu kết nối 72 GPU trong một máy chủ NVL72.

- ConnectX-9 SuperNIC: Giao diện mạng tốc độ cao, độ trễ cực thấp cho kết nối scale-out giữa các rack và cụm máy chủ.

- BlueField-4 DPU: Bộ xử lý dữ liệu không chỉ quản lý cơ sở hạ tầng mà còn cung cấp nền tảng cho Nvidia Inference Context Memory Storage - giải pháp lưu trữ bản địa dành riêng cho AI, cần thiết để xử lý dữ liệu ngữ cảnh khổng lồ từ các mô hình nghìn tỷ tham số.

- Spectrum-6 Ethernet Switch: Công tắc Ethernet scale-out sử dụng quang học đóng gói chung, tăng hiệu quả và độ tin cậy cho toàn bộ trung tâm dữ liệu.

Kiến trúc này cho phép mở rộng quy mô liền mạch từ một siêu chip lên đến DGX SuperPOD - siêu máy tính AI quy mô lớn được tạo thành từ nhiều máy chủ Vera Rubin NVL72 (mỗi máy chủ chứa 72 GPU). Đây chính là thứ mà các “gã khổng lồ” siêu cường (hyperscaler) như Microsoft, Google, Amazon và Meta đang chi hàng tỷ USD để sở hữu.

Hiệu quả vượt trội

NVIDIA công bố những con số khiến cả ngành công nghiệp phải chú ý về hiệu quả của Rubin so với thế hệ Blackwell trước đó. Đầu tiên, nền tảng mới giảm 4 lần số lượng GPU cần thiết để huấn luyện cùng một mô hình Hỗn hợp Chuyên gia (Mixture-of-Experts - MoE). MoE là kiến trúc mô hình tiên tiến, kết hợp nhiều mạng lưới “chuyên gia” con và định tuyến câu hỏi đến chuyên gia phù hợp, giúp mở rộng quy mô mô hình một cách hiệu quả.

Việc cắt giảm đáng kể số GPU này không chỉ tiết kiệm chi phí đầu tư ban đầu mà còn mang lại tính linh hoạt chiến lược: các doanh nghiệp có thể dùng lượng GPU dư thừa đó để thực hiện các tác vụ khác, tối đa hóa hiệu suất sử dụng tổng thể.

Thứ hai, và có lẽ quan trọng hơn trong giai đoạn triển khai AI hàng loạt hiện nay, Rubin cắt giảm 10 lần chi phí token suy luận. Token là đơn vị cơ bản mà mô hình AI sử dụng để xử lý thông tin, có thể đại diện cho một từ, một phần câu, một mảnh hình ảnh hay video.

Xử lý token, đặc biệt với các mô hình khổng lồ, là quá trình ngốn tài nguyên và tốn năng lượng. Việc giảm 90% chi phí này trực tiếp cải thiện Tổng chi phí sở hữu (TCO) và mở ra cánh cửa cho việc triển khai thương mại hóa các ứng dụng AI phức tạp, đòi hỏi ngữ cảnh dài (long-context) và lý luận nhiều bước.

Các nguồn độc lập như Tom's Hardware và The Verge còn xác nhận rằng GPU Rubin mang lại hiệu suất suy luận cao hơn đến 5 lần ở một số tác vụ, củng cố thêm lợi thế về hiệu quả năng lượng.

Bối cảnh cạnh tranh

Dù đang ở đỉnh cao quyền lực với vốn hóa thị trường khoảng 4.6 nghìn tỷ USD (tính đến đầu tháng 1/2026), NVIDIA ý thức rõ ràng về những thách thức đang lớn dần. Áp lực đến từ ba phía chính: đối thủ truyền thống, khách hàng lớn tự phát triển chip, và những lo ngại về sự bền vững của chính thị trường AI.

Đối thủ trực tiếp nhất là AMD, khi hãng này đang chuẩn bị ra mắt hệ thống rack-scale Helios để cạnh tranh với NVL72 của NVIDIA. Theo phân tích từ Tom's Hardware và The Register, Helios dựa trên thiết kế mở sử dụng Ethernet, tích hợp GPU Instinct MI455X và hứa hẹn dung lượng bộ nhớ cao hơn 50%, cùng khả năng bảo trì dễ dàng hơn. Dù vậy, giới phân tích nhận định NVIDIA vẫn giữ lợi thế nhờ hệ sinh thái phần mềm CUDA độc quyền và khép kín, cùng hiệu suất thực tế vượt trội trong nhiều tác vụ chuyên sâu.

Mối đe dọa tinh vi hơn đến từ chính những khách hàng lớn nhất của NVIDIA. Tháng 10/2025, Google và Amazon thông báo Anthropic - công ty đứng sau mô hình Claude - sẽ mở rộng việc sử dụng chip tự thiết kế của họ. Cụ thể, Anthropic dự kiến sử dụng một triệu TPU của Google Cloud và một triệu chip Trainium 2 của AWS để phát triển Claude. Hơn nữa, theo The Information, Google còn đang đàm phán với Meta và các nhà cung cấp đám mây khác về việc sử dụng TPU trong trung tâm dữ liệu của họ, trực tiếp xâm nhập “sân nhà” của NVIDIA.

Bên cạnh đó, thị trường cũng xuất hiện những dấu hiệu cảnh giác. Vốn hóa của NVIDIA đã giảm từ mức đỉnh hơn 5 nghìn tỷ USD hồi tháng 10/2025, một phần do lo ngại về “bong bóng AI” và khả năng chi tiêu vốn của các doanh nghiệp có thể chậm lại. Các nhà đầu tư đang đặt câu hỏi về tính bền vững của đà tăng trưởng thần tốc này.

Tầm nhìn tương lai

Jensen Huang nhiều lần nhấn mạnh rằng tương lai của điện toán là “nhà máy AI” (AI factories). Rubin chính là nền tảng phần cứng then chốt để hiện thực hóa tầm nhìn đó. Khác với trung tâm dữ liệu truyền thống phục vụ các yêu cầu tính toán ngắt quãng, một nhà máy AI hoạt động như một dây chuyền sản xuất liên tục, biến đổi năng lượng và dữ liệu thô thành “trí thông minh” có thể sử dụng.

Các nhà phân tích từ SiliconAngle và AInvest đồng thuận rằng Rubin không đơn thuần là một nâng cấp chu kỳ, mà là bước đệm cho sự chuyển đổi mô hình này. Khả năng xử lý hiệu quả các mô hình nghìn tỷ tham số, ngữ cảnh dài và đường ống đa phương thức (multimodal) của Rubin sẽ cho phép tạo ra thế hệ tác nhân AI (AI agents) thực sự tự chủ, có khả năng lý luận phức tạp và thực hiện chuỗi tác vụ dài.

Sự chấp nhận từ các lãnh đạo công nghệ hàng đầu thế giới càng củng cố cho vị thế này. Sam Altman (CEO OpenAI) nhận xét nền tảng Rubin giúp “mở rộng tiến bộ để trí thông minh nâng cao mang lại lợi ích cho mọi người”. Mark Zuckerberg (CEO Meta) kỳ vọng Rubin mang lại “bước thay đổi về hiệu suất và hiệu quả cần thiết để triển khai các mô hình tiên tiến nhất cho hàng tỷ người”. Trong khi đó, Satya Nadella (CEO Microsoft) tiết lộ họ đang xây dựng “các siêu nhà máy AI mạnh mẽ nhất thế giới” với sự hỗ trợ của Rubin.

Về lộ trình thương mại, NVIDIA cho biết đang lấy mẫu nền tảng Rubin với các đối tác và đã vào giai đoạn sản xuất đầy đủ. Các dịch vụ điện toán đám mây lớn như AWS, Google Cloud, Microsoft Azure và Oracle Cloud Infrastructure dự kiến sẽ cung cấp các instance chạy trên Vera Rubin bắt đầu từ nửa sau năm 2026.

Kết luận

Sự ra mắt nền tảng Vera Rubin tại CES 2026 không chỉ là một mốc kỹ thuật, mà là một tuyên ngôn chiến lược của NVIDIA. Trong một động thái chủ động, họ tự thiết lập nhịp độ đổi mới một năm/lần, đặt áp lực lên tất cả đối thủ trong ngành.

Những cải tiến về hiệu suất - giảm 4 lần GPU huấn luyện, 5 lần hiệu suất suy luận, 10 lần chi phí token - không đơn thuần là những con số tiếp thị, mà là thứ sẽ trực tiếp định hình kinh tế học của làn sóng AI tiếp theo, mở ra cánh cửa cho những ứng dụng mà trước đây là bất khả thi về mặt chi phí.

Dù phải đối mặt với cuộc tấn công ba mũi giáp công từ AMD, từ các khách hàng lớn tự sản xuất chip, và từ những lo ngại về thị trường, NVIDIA vẫn giữ vững lợi thế khó có thể xói mòn trong ngắn hạn. Lợi thế đó đến từ hệ sinh thái phần mềm CUDA khép kín và đã trưởng thành, từ khả năng “đồng thiết kế cực độ” cho phép tối ưu hóa toàn hệ thống, và từ tầm nhìn “nhà máy AI” đang ngày càng được hiện thực hóa.

Cuộc đua AI đang bước vào một chương mới, khốc liệt và tốn kém hơn bao giờ hết. Với Rubin, NVIDIA không chỉ đang bán phần cứng; họ đang bán cả tương lai của chính ngành công nghiệp AI, và hiện tại, không có ai khác sẵn sàng giao nó một cách thuyết phục đến vậy.